Es geht weiter mit den Manipulations-Tricks, die im Internet ihr Unwesen treiben. Deep-Fakes bringen Fake-News auf das nächste Level.

Was sind Deep-Fakes und was unterscheidet sie von Fake-News?

“Deep-Fakes” ist ein Wortspiel, welches aus “Deep-Learning” und “Fakes” zusammengesetzt ist. Deep-Fakes sind mithilfe von KI erzeugte Bilder, Audios oder Videos, in denen Fakes von Personen, Orten oder Gegenständen generiert werden. Diese Inhalte wirken so echt, dass man sie kaum von echten Personen, Orten oder Gegenständen unterscheiden kann.

Der Unterschied zwischen Fake-News und Deep-Fakes:

- Fake-News sehen aus wie echte Nachrichten, damit man diese ernst nimmt. Das Ziel solcher Fake-News ist es, falsche Informationen zu verbreiten.

- Deep-Fakes sind KI-generierte Abbildungen, Videos oder Tonaufnahmen. Diese Abbildungen wirken absolut echt und sind kaum vom Original zu unterscheiden. Zum Beispiel wie die KI-generierte Rede von Obama.

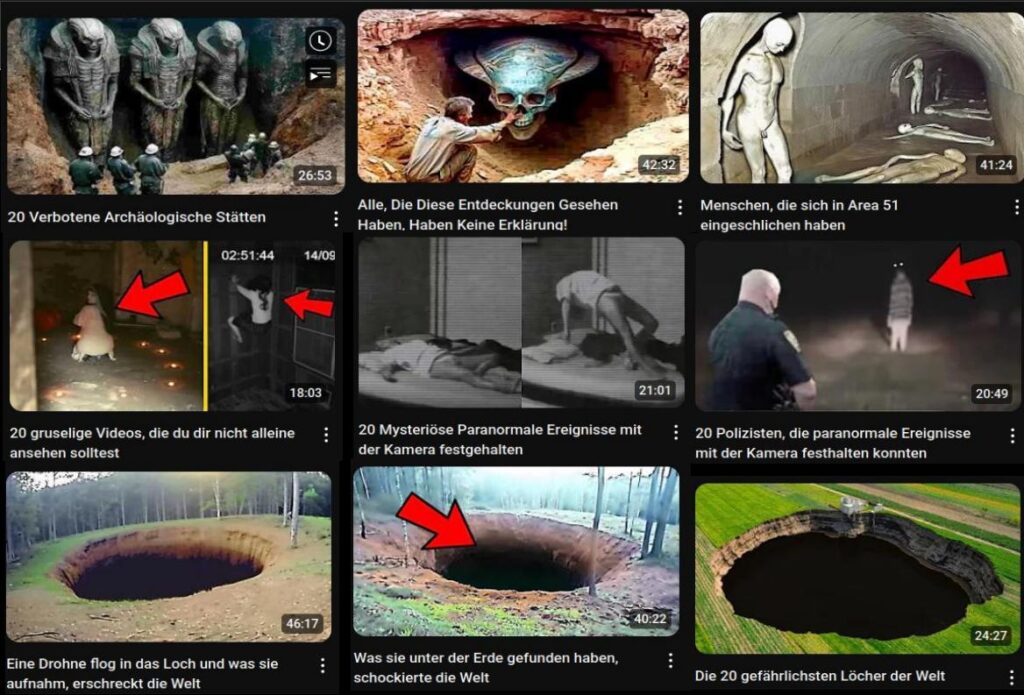

Der Schritt, Fake-News und Deep-Fakes miteinander zu verbinden, ist nicht besonders weit. Die ersten Anfänge einer solchen Verbindung deckte der freie Journalist Mats Schönauer auf, der den Kanal “Topf voll Gold” betreibt. Der Kanal gehört seit 2016 zu dem Magazin “Über-Medien”. Mats fand bei seinen Recherchen über hundert Kanäle, welche in Massen KI-generierte Inhalte erstellen. Einer dieser Kanäle, über die er berichtet ist “Die Weise Eule”. Dieser bezeichnet sich selbst als Bildungskanal und richtet sich in erster Linie an Kinder und Jugendliche. Die Themen sind häufig mysteriöser Natur. Ob Aliens, Geister oder … tiefe Löcher im Erdboden? Egal: Je abgedrehter desto besser.

Oha, woran können wir denn Kanäle erkennen, deren Inhalte KI-generiert sind?

Es ist zwar nicht einfach, aber im Moment gibt es noch Möglichkeiten, solche Kanäle zu erkennen. Wir möchten euch aber darauf hinweisen, dass viele dieser Kanalbetreiber:innen eher wenig Erfahrung im Umgang mit KI-Tools haben. Das heißt, die Hinweise gelten nur solange, bis die Personen hinter den Kanälen in der Lage sind, KI-Tools besser einzusetzen. Die Hinweise gelten ebenfalls nicht für jedes einzelne Video, sondern sollten eher als “Red Flags1” betrachtet werden.

Für KI-Videos wird häufig Clickbait eingesetzt

“Clickbait” ist eine Methode, um Nutzer:innen zu locken, auf ein Video zu klicken. Meistens wird dazu Neugierde als Mittel benutzt. Der Titel ist dabei so gestaltet, dass dieser nur einen Teil der Information liefert. Zum Beispiel: “Alle, die dieses Video gesehen haben, konnten es nicht glauben!!!”. Das kann man dann mit einem Bild von einem schwebenden Mädchen als Thumbnail kombinieren, so dass natürlich Alle wissen wollen, was dahintersteckt. Voila! Euer Video hat das Potential, sehr häufig geklickt zu werden. Auf dem Kanal der “Weisen Eule” findet ihr einen ganzen Haufen solcher Beispiele.

Das liegt vor allem daran, weil wir Menschen nach Wissen streben. Clickbait-Überschriften setzen genau dort an, da sie versuchen Spannung zu erzeugen, ohne Einblick in den eigentlichen Inhalt zu liefern. Unser Verstand benötigt vollständige Informationen, weshalb unser Gehirn die fehlenden Informationen für uns erstellt. Wenn wir zum Beispiel eine Person sehen, die hinter einer Säule verschwindet, dann erwarten wir, dass sie kurze Zeit später auf der anderen Seite wieder auftaucht. Manchmal vergessen wir sogar, dass die Person für einen Moment von einer Säule bedeckt war. Unser Gehirn fügt die fehlenden Informationen einfach ganz automatisch hinzu. Genauso geht es uns bei Clickbait. Unser Verstand ersetzt die fehlenden Informationen für uns durch eine gewisse Erwartung, die wir haben. In unserem Beispiel mit dem Mädchen würden wir erwarten, dass es um einen Geist geht oder dass das Mädchen Levitation2 kann, da der Titel auf etwas Unglaubliches hindeutet. Wir sind geneigt auf das Video zu klicken, weil es unsere tiefsten Gefühle wie Furcht oder Aufregung anspricht. Aus dem Selben Grund schauen wir uns Horror- oder Liebesfilme an. Allerdings stellt sich bei den meisten Clickbait-Videos heraus, dass der eigentliche Inhalt eher langweilig ist und zum Teil nichts mit der Überschrift und dem Thumbnail zu tun hat.

Einsatz einer KI-Stimme

Es ist nicht leicht, diese KI generierten Stimmen zu erkennen, da sie aus unserer Sicht wirklich gut gemacht sind. Trotzdem sind sie nicht perfekt und klingen bei längerem Zuhören immer eine Spur daneben. Manchmal imitiert die KI auch Akzente, wie in den Videos der “Weisen Eule”. In diesen Videos werden immer die Top 10, Top 20 und so weiter angesprochen. Die KI imitiert hier einen Stilwechsel für jedes Video, was für diese Art von Videos unnötig ist und sogar unpassend wirkt. Die KI-generierten Stimmen haben zum Teil ebenfalls Probleme Emotionen in ihrer Stimme richtig klingen zu lassen. In diesem Video sagt die KI zum Beispiel “Surprise” in einer eher monotonen Stimmlage. Es ist daher schwer zu sagen, ob es sich um Überraschung oder Sarkasmus handelt. Im Medienradar beschreibt Lea Uhlenbrock, was KI ebenfalls tut, das auf uns unpassend wirkt. Da die KI-Stimmen letzten Endes Text wiedergeben, könnt ihr euch auch an den KI-Fehlern für Text orientieren, die im Medienradar beschrieben werden.

Die KI macht inhaltliche Fehler

Die KI sucht sich ihr Material aus dem Internet. Das heißt, dass Vieles von dem, was in den Videos zu finden ist, auch in irgendeiner Form im Internet oder an anderer Stelle steht. Allerdings passieren der KI manchmal sogenannte Halluzinationen. Das heißt, dass die KI fehlende Informationen einfach mit anderen Informationen füllt, die zwar nichts mit dem eigentlichen Thema zu tun haben, aber plausibel sind. So können zum Beispiel Bilder mit den falschen Personen, Orten, Zeitpunkten oder Gegenständen benannt werden. Daher reicht es nicht, nur zu schauen, ob die im Video genannten Inhalte im Internet zu finden sind, sondern man muss auch überprüfen, ob die Inhalte, die im Internet genannt werden, richtig sind. Ein Beispiel dafür ist wieder dieses Video, mit dem Titel “7 Canceled Disney Princesses We’ll Never Get to See”. Im ersten Beispiel behauptet die KI, dass Schneewittchen die Schwester von Rosenrot sei. Was für viele Menschen im deutschsprachigen Raum, die mit den Geschichten der Gebrüder Grimm groß geworden sind, offensichtlich falsch ist, ist für die KI ziemlich logisch. Im englischen wird Schneewittchen mit Snow White übersetzt. Die Geschichte Schneeweißchen und Rosenrot ist im englischen Snow White and Rose Red. Die KI verbindet daher beide Geschichten miteinander, weil in beiden Geschichten die Bezeichnung “Snow White” vorkommt. Dadurch können dann diese von der KI produzierten Fehlinformationen entstehen. Wir können daher Alle mit dem Wissen, dass Disney vermutlich keine dieser Filme gecancelt hat, wieder beruhigt schlafen.

Was könnt ihr tun?

Die KI bindet häufig Bilder in den Videos ein. Falls ihr euch bei einem Video nicht sicher seid, ob der Inhalt stimmt, dann stoppt das Video und macht einfach mal einen Screenshot von einem der Bilder, öffnet die Google Rückwärts-Bildersuche und kopiert euren Screenshot da rein. Danach werden euch alle Seiten angezeigt, in denen das Bild bereits verwendet wurde. Nutzt Querverweise: So könnt ihr überprüfen, ob bereits andere Medien darüber berichtet haben.

Wenn KI so eine Bedrohung ist, weil sie unsere Meinung und unser Weltbild manipuliert, warum tut unsere Regierung dann nichts dagegen?

Natürlich sind KI-Systeme im Allgemeinen nicht das Problem, sondern der Missbrauch dieser Systeme. Dafür hat die EU den AI Act (deutsch KI-Verordnung) verabschiedet, die seit dem 01.08.2024 gilt. Diese Verordnung umfasst verschiedene Maßnahmen, um KI-Systeme in der EU zu regulieren:

- Transparenz soll vermeiden, dass die KI-Systeme illegale Inhalte generieren. Dabei werden die Trainingsdaten veröffentlicht und KI-generierte Inhalte erhalten eine Kennzeichnung. Diese Kennzeichnung funktioniert wie die Kennzeichnung von Werbung in You-Tube Videos.

- Klassifikation in verschiedene Risikostufen. Je höher die Einstufung des Risikos ist, desto strenger wird die Einhaltung der Richtlinien reguliert.

- Einführung von Leitlinien, damit die erlassenen Verordnungen EU-weit eingeführt und Verstöße verfolgt und bestraft werden können.

Auch wenn wir anhand dieser Tipps nicht jeden Deep-Fake erkennen werden, hilft es aber schon einmal, das Grundgerüst im kritischen Denken, besonders in Bezug auf Medieninhalte auszubauen. Die technologischen Möglichkeiten entwickeln sich und genauso die Tricks derjenigen, die uns hereinlegen möchten. Daher ist es gut, diese Tricks zu kennen und auch auf andere Bereiche anwenden zu können.

Kennt ihr ebenfalls Tricks, um andere Leute im Internet hereinzulegen? Wie geht ihr damit um? Schreibt uns eure Erfahrungen in die Kommentare.

Bleibt neugierig und stellt Fragen, denn die Welt hat noch viele Geheimnisse versteckt!

Weiterführende Beiträge

- Täuschend echt: So erkennen Sie KI-Content (2024): https://www.onlinesicherheit.gv.at/Services/News/KI-Inhalte-erkennen.html

- Was sind Deepfakes? (2025): https://www.jugendschutz.net/themen/geraete-und-technik/artikel/was-sind-deepfakes

- Wir jagen den größten Fake-Kanal auf YouTube 🦉🇩🇪 | Paluten reagiert 70 Mal?! (2025): https://www.youtube.com/watch?v=VNpndfvorc4

- Red Flags sind Hinweise darauf, dass bestimmte Dinge merkwürdig sind. Jede einzelne Red Flag ist dabei kein KO-Kriterium, aber sie geben dir den Hinweis aufzupassen und bestimmte Dinge nachzuprüfen. ↩︎

- Jemand hat die Fähigkeit durch die Kraft seiner Gedanken zu schweben. ↩︎

Bildcover: Dr. Rebecca Wismeg-Kammerlander

Schreibe einen Kommentar